The Artificial Emotions Curator

(and his fork project Articifial Eyes)

Master pieces through the Microsoft Emotion API eyes

|

The Artificial Emotions Curator

|

The Artificial Emotions Curator

|

|

Deep Learning (loosing control) Moving the human being from the center of the scene and focusing directly on the devices, Fiedrich Kittler disagrees with McLuhan and his vision of the media as a prosthesis of the body. According to the German theorist, technology follows its own evolutionary path. The devices not only do not intend to improve the human senses but seek to replace them, due to their greater efficiency and their lower level of error. Artificial vision replaces the human eye in the assembly line, since they are provided with a greater range of perception within the light spectrum, a greater speed of recognition of malformations in the product, a greater resistance to forced labour and a lower cost of maintenance. But the senses -organic or electronic- are just the superficial layer within the machinic labelling and data processing agencement (assemblage) in which, although a human part intervenes -as a "soft" sensor and as a voluntary slave in the data-entry of experiences to neural networks- it is fundamentally the algorithms the ones that channel their classification and control the flow of this incomprehensible and futile, Sisyphus like work: mass digitization, or, in the case of the human component, its "devenir code” (becoming code).

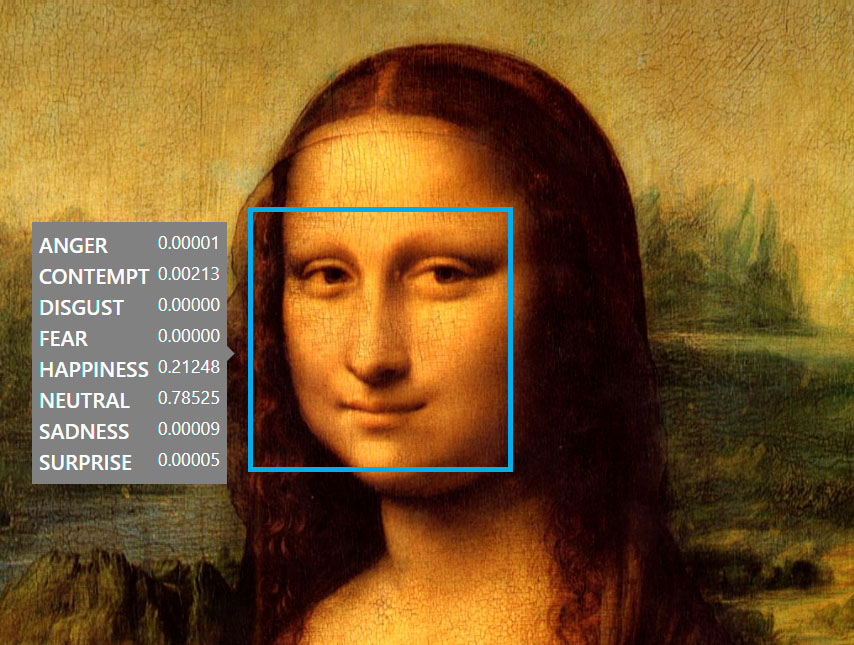

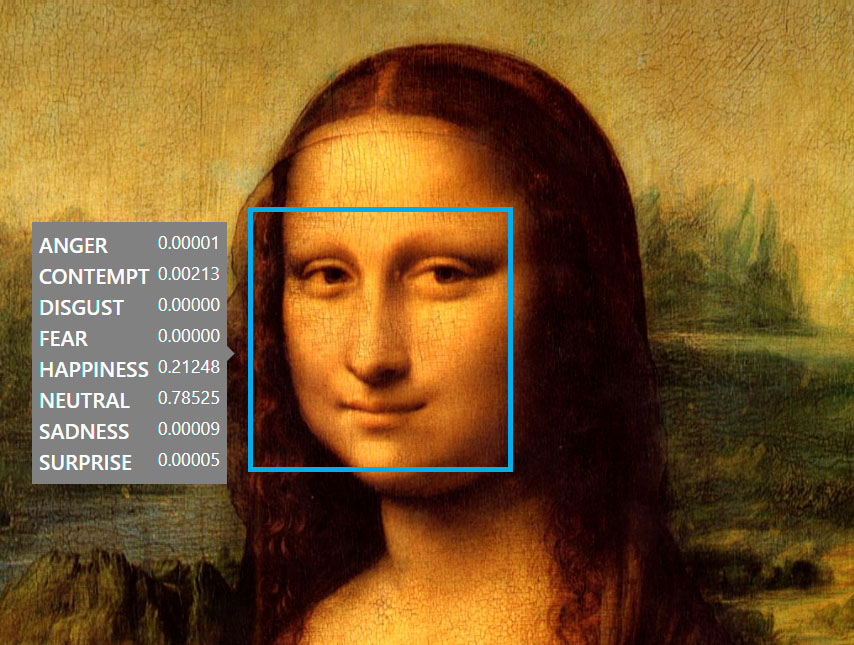

Backpropagation and curatorship What at first may seem banal to us - the game of a machine that clumsily tries to interpret the inscrutability of human gestures - should make us reflect, at least if we consider that this API, open for public use, is only a decaffeinated tool. Something more robust - but equally arbitrary - is the package of algorithms that are already being used in the intelligence agencies - to analyse the people attending the demonstrations or protests -, by the lobbies that surround the governments - to interpret the reactions during every political discourse-, or by the defence agencies -to identify potential terrorists-. Only by their faces, only by their gestures. For this project I have submitted an arbitrary selection of masterpieces to the machinic vision and intelligence of this Microsoft algorithm. Thanks to this, for example, we can finally end the discussion about the enigmatic smile of the Mona Lisa, confirm the happiness of Velázquez when painting his Meninas or recognize the current inability of the machine to understand Cubism, among other things.

Forking paths Another fork of the initial project - still in experimental phase - contemplates the use of an own algorithm, based on a radical modification of the Microsoft API. The project will also allow its public and interactive use through an online platform. There is still no publication date or definitive name for this fork. |

Deep Learning (perdiendo el control) Moviendo del centro de la escena al ser humano, y enfocándose directamente en los dispositivos, Fiedrich Kittler disiente con McLuhan y su visión de los medios como prótesis del cuerpo ya que, según él, la tecnología sigue su propio camino evolutivo y, en todo caso, en relación a los sentidos humanos, el teórico alemán considera que los dispositivos no sólo no pretenden mejorarlos, sino que buscan reemplazarlos, debido a su mayor eficiencia y su menor nivel de error. La visión artificial reemplaza en la cadena de montaje al ojo humano, al estar provista de un mayor rango de percepción dentro del espectro lumínico, una mayor velocidad de reconocimiento de malformaciones en el producto, una mayor resistencia al trabajo forzado y un menor coste de mantenimiento. Pero los sentidos -orgánicos o electrónicos- son apenas la capa superficial dentro del agenciamiento maquínico de etiquetación y procesamiento de datos en el que si bien interviene una parte humana -como sensor “blando” y como esclavo voluntario en el data-entry de experiencias a las redes neuronales- son fundamentalmente los algoritmos, quienes encauzan su clasificación y controlan el flujo de este trabajo inabarcable y fútil, propio de Sísifo: la digitalización masiva, o, en el caso de componente humano, su “devenir código”.

Retropropagacíon y curaduría Lo que en un principio nos puede parecer banal -el juego de una máquina que torpemente intenta interpretar lo inescrutable de la gestualidad humana- debería hacernos reflexionar, al menos si tenemos en cuenta que esta API de uso público es sólo una herramienta descafeinada. Algo bastante más robusto -pero igualmente arbitrario- es el paquete de algoritmos que ya están usándose en las agencias de inteligencia -para analizar a los concurrentes a las manifestaciones o protestas-, por los lobbies que rodean a los gobiernos -para interpretar las reacciones durante cada discurso político-, o por las agencias de defensa -para identificar potenciales terroristas-. Sólo por sus caras, sólo por sus gestos. Para este proyecto he sometido a una selección arbitraria de obras maestras de la pintura, a la visión y a la inteligencia maquínica de este algoritmo de Microsoft. Gracias a ello podremos acabar finalmente con la discusión acerca de la enigmática sonrisa de la Mona Lisa, confirmar la felicidad de Velázquez al pintar sus Meninas o reconocer la incapacidad actual de la máquina para entender el cubismo, entre otras cosas.

Forking paths Otro fork del proyecto inicial -aún en fase experimental- contempla el uso de un algoritmo propio, basado en una modificación radical del API de Microsoft. El proyecto además permitirá su uso público e interactivo a través de una plataforma online. Aún no hay fecha de publicación ni nombre definitivo para este fork. |

Gustavo Romano